本文主要介绍了pytorch中的一些损失函数:1. nn.L1Loss 2. nn.SmoothL1Loss 3. nn.MSELoss 4. nn.CrossEntropyLoss

loss ( x i , y i ) = ∣ x i − y i ∣ \operatorname{loss}\left(x_{i}, y_{i}\right)=\left|x_{i}-y_{i}\right|

l o s s ( x i , y i ) = ∣ x i − y i ∣

1 2 3 4 5 6 Examples:: >>> loss = nn.L1Loss(reduction='sum') >>> input = torch.tensor([1., 2, 3, 4]) >>> target = torch.tensor([4., 5, 6, 7]) >>> output = loss(input, target) >>> print(output)

函数nn.L1Loss有一个参数reduction,reduction有三个参数分别是:none、sum、elementwise_mean,当reduction=none时,返回的是一个向量(batch_size)如tensor([3., 3., 3., 3.]);当reduction=sum时,函数返回的是tensor(12.);当reduction=elementwise_mean时,函数返回的是tensor(3.)

loss ( x i , y i ) = { 1 2 ( x i − y i ) 2 if ∣ x i − y i ∣ < 1 ∣ x i − y i ∣ − 1 2 , otherwise \operatorname{loss}\left(\mathbf{x}_{i}, \mathbf{y}_{i}\right)=\left\{\begin{array}{cc}

\frac{1}{2}\left(\mathbf{x}_{i}-\mathbf{y}_{i}\right)^{2} & \text { if }\left|\mathbf{x}_{i}-\mathbf{y}_{i}\right|<1 \\

\left|\mathbf{x}_{i}-\mathbf{y}_{i}\right|-\frac{1}{2}, & \text { otherwise }

\end{array}\right.

l o s s ( x i , y i ) = { 2 1 ( x i − y i ) 2 ∣ x i − y i ∣ − 2 1 , if ∣ x i − y i ∣ < 1 otherwise

关于x i − y i \mathbf{x}_{i}-\mathbf{y}_{i} x i − y i

loss ′ ( x i , y i ) = { x i − y i if ∣ x i − y i ∣ < 1 1 if x i − y i > 1 − 1 if x i − y i < − 1 \operatorname{loss}^{\prime}\left(\mathbf{x}_{i}, \mathbf{y}_{i}\right)=\left\{\begin{array}{cc}

\mathbf{x}_{i}-\mathbf{y}_{i} & \text { if }\left|\mathbf{x}_{i}-\mathbf{y}_{i}\right|<1 \\

1 & \text { if } \mathbf{x}_{i}-\mathbf{y}_{i}>1 \\

-1 & \text { if } \mathbf{x}_{i}-\mathbf{y}_{i}<-1

\end{array}\right.

l o s s ′ ( x i , y i ) = ⎩ ⎪ ⎨ ⎪ ⎧ x i − y i 1 − 1 if ∣ x i − y i ∣ < 1 if x i − y i > 1 if x i − y i < − 1

1 2 3 4 5 6 7 8 9 10 11 import torch import torch.nn as nn import torch.nn.functional as F a = torch.tensor([1., 2, 3, 4]) b = torch.tensor([1.1, 5, 6, 7]) loss_fn = nn.SmoothL1Loss(reduction='none') loss = loss_fn(a, b) print(loss) #out tensor([0.0050, 2.5000, 2.5000, 2.5000])

loss ( x i , y i ) = ( x i − y i ) 2 \operatorname{loss}(\mathbf{x}_{i}, \mathbf{y}_{i})=(\mathbf{x}_{i}-\mathbf{y}_{i})^{2}

l o s s ( x i , y i ) = ( x i − y i ) 2

1 2 3 4 5 6 7 a = torch.tensor([1., 2, 3, 4]) b = torch.tensor([4., 5, 6, 7]) loss_fn = nn.MSELoss(reduce=True, size_average=True) loss = loss_fn(a, b) print(loss) #out tensor(9.)

两个输入必须要是同一个类型的,当reduce=True返回的是一个标量,当reduce=False返回一个向量;当size_average = True,返回 loss.mean();如果 size_average = False,返回 loss.sum()。默认情况下:两个参数都为True。

交叉熵 :它主要刻画的是实际输出(概率)与期望输出(概率)的距离,也就是交叉熵的值越小,两个概率分布就越接近。假设概率分布p为期望输出,概率分布q为实际输出,H ( p , q ) H(p, q) H ( p , q )

H ( p , q ) = ∑ x p ( x ) log q ( x ) H(p, q)=\sum_{x} p(x) \log q(x)

H ( p , q ) = x ∑ p ( x ) log q ( x )

在神经网络中通过Softmax回归将前向传播得到的结果变成概率分布,这是一个常用且有用的方法。

Softmax ( z i ) = e z i ∑ c = 1 C e z c \operatorname{Softmax}\left(z_{i}\right)=\frac{e^{z_{i}}}{\sum_{c=1}^{C} e^{z_{c}}}

S o f t m a x ( z i ) = ∑ c = 1 C e z c e z i

其中 z i z_{i} z i q 1 q_{1} q 1 q 2 q_{2} q 2 H ( p , q 1 ) = − ( 1 log 0.5 + 0 log 0.4 + 0 log 0.1 + 0 log 0.5 + 1 log 0.6 + 1 log 0.9 ) ) = 0.3 \left.H\left(p, q_{1}\right)=-(1 \log 0.5+0 \log 0.4+0 \log 0.1+0 \log 0.5+1 \log 0.6+1 \log 0.9)\right)=0.3 H ( p , q 1 ) = − ( 1 log 0 . 5 + 0 log 0 . 4 + 0 log 0 . 1 + 0 log 0 . 5 + 1 log 0 . 6 + 1 log 0 . 9 ) ) = 0 . 3 H ( p , q 2 ) = − ( 1 log 0.8 + 0 log 0.1 + 0 log 0.1 + 0 log 0.2 + 1 log 0.9 + 1 log 0.9 ) ) = 0.19 \left.H\left(p, q_{2}\right)=-(1 \log 0.8+0 \log 0.1+0 \log 0.1+0 \log 0.2+1 \log 0.9+1 \log 0.9)\right)=0.19 H ( p , q 2 ) = − ( 1 log 0 . 8 + 0 log 0 . 1 + 0 log 0 . 1 + 0 log 0 . 2 + 1 log 0 . 9 + 1 log 0 . 9 ) ) = 0 . 1 9 q 2 q_{2} q 2 为什么要使用交叉熵损失函数呢? los s = 1 2 m ∑ i m ( y i − y ′ ) 2 \operatorname{los} s=\frac{1}{2 m} \sum_{i}^{m}\left(y_{i}-y^{\prime}\right)^{2} l o s s = 2 m 1 ∑ i m ( y i − y ′ ) 2 y i y_{i} y i y ′ y^{\prime} y ′ m \mathrm{m} m

los s i = ( y i − y i ′ ) 2 = ( y i − e y i ′ ∑ j = 1 n e y i ′ ) 2 \operatorname{los} s_{i}=\left(y_{i}-y^{i^{\prime}}\right)^{2}=\left(y_{i}-\frac{e^{y_{i}^{\prime}}}{\sum_{j=1}^{n} e^{y_{i^{\prime}}}}\right)^{2}

l o s s i = ( y i − y i ′ ) 2 = ( y i − ∑ j = 1 n e y i ′ e y i ′ ) 2

其中 y i y_{i} y i ∑ j = 1 n e y i ′ \sum_{j=1}^{n} e^{y_{i}^{\prime}} ∑ j = 1 n e y i ′

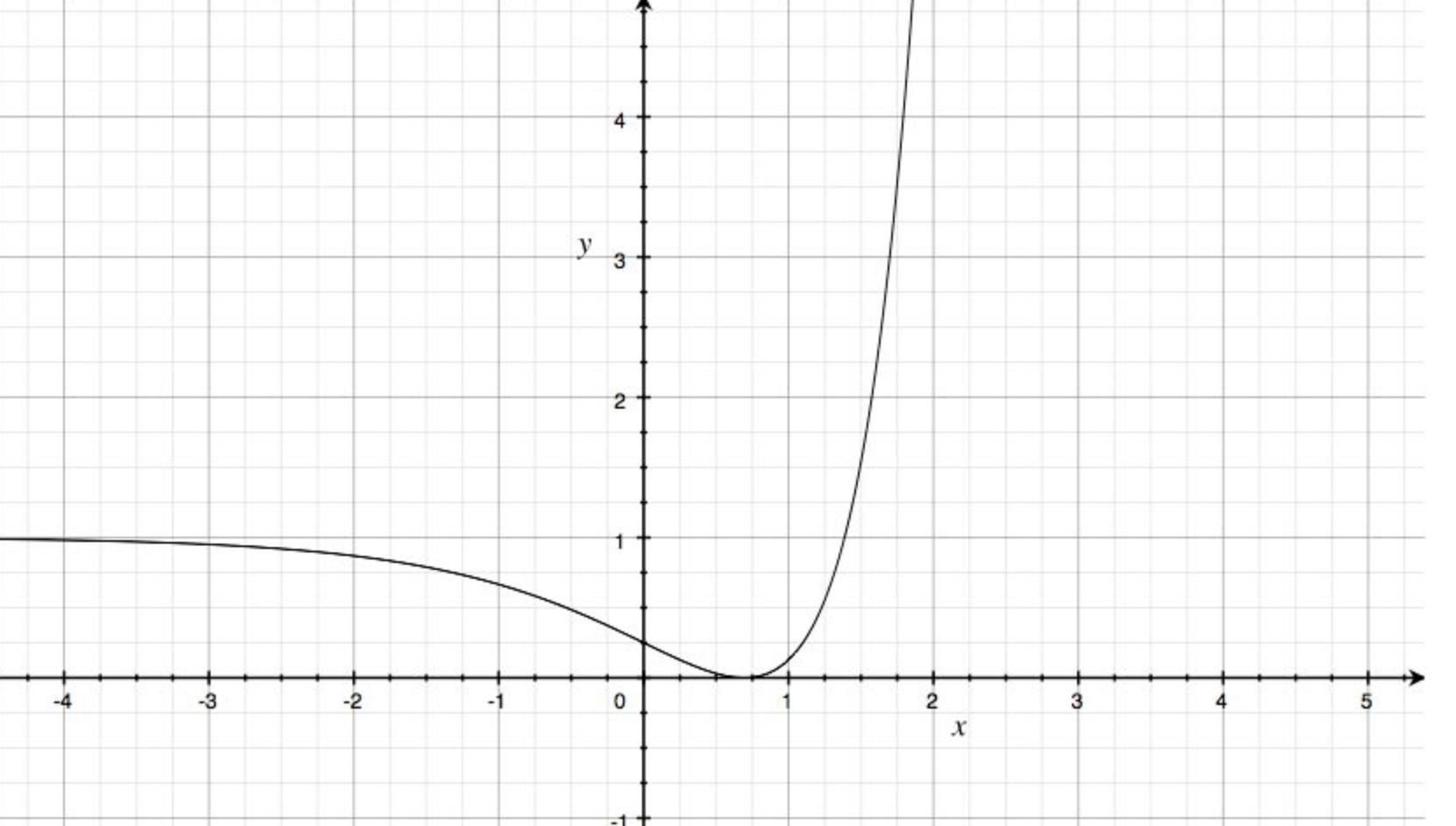

loss i = ( c 1 − e y i ′ c 2 ) 2 \operatorname{loss}_{i}=\left(c_{1}-\frac{e^{y i^{\prime}}}{c_{2}}\right)^{2}

l o s s i = ( c 1 − c 2 e y i ′ ) 2

取 c 1 = 1 , c 2 = 2 c_{1}=1, c_{2}=2 c 1 = 1 , c 2 = 2

loss = − ∑ i = 1 n y i ∗ log ( y ′ ) \operatorname{loss}=-\sum_{i=1}^{n} y_{i} * \log \left(y_{\prime}\right)

l o s s = − i = 1 ∑ n y i ∗ log ( y ′ )

还是一样, y i y_{i} y i y ′ y^{\prime} y ′ loss \operatorname{loss} l o s s

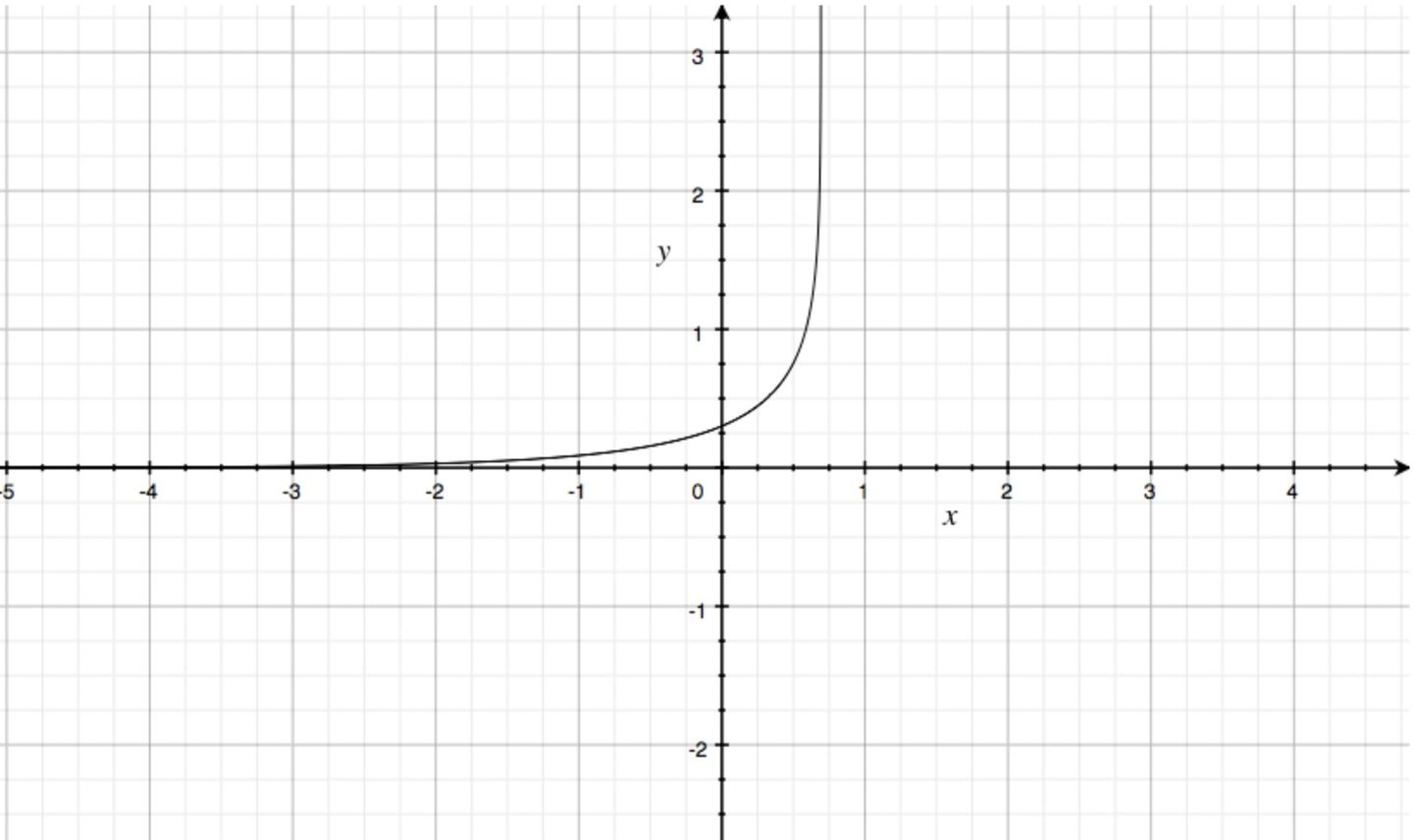

loss i = − log ( y ′ ) \operatorname{loss}_{i}=-\log \left(y^{\prime}\right)

l o s s i = − log ( y ′ )

加入 (softmax) 得:

loss i = − log ( c 1 − e x c 2 ) \operatorname{loss}_{i}=-\log \left(c_{1}-\frac{e^{x}}{c_{2}}\right)

l o s s i = − log ( c 1 − c 2 e x )

取 c 1 = 1 , c 2 = 2 c_{1}=1, c_{2}=2 c 1 = 1 , c 2 = 2 loss \operatorname{loss} l o s s

loss ( x , class ) = − log ( exp ( x [ class ] ) ∑ j exp ( x [ j ] ) ) = − x [ class ] + log ( ∑ j exp ( x [ j ] ) ) \operatorname{loss}(x, \text { class })=-\log \left(\frac{\exp (x[\text { class }])}{\sum_{j} \exp (x[j])}\right)=-x[\text { class }]+\log \left(\sum_{j} \exp (x[j])\right)

l o s s ( x , class ) = − log ( ∑ j exp ( x [ j ] ) exp ( x [ class ] ) ) = − x [ class ] + log ( j ∑ exp ( x [ j ] ) )

1 2 3 4 5 6 7 entroy = nn.CrossEntropyLoss() input = torch.Tensor([[-0.7715, -0.6205, -0.2562]]) target = torch.tensor([0]) output = entroy(input, target) print(output) #output tensor(1.3447)

按公式计算如下:

− x [ 0 ] + log ( exp ( x [ 0 ] ) + exp ( x [ 1 ] ) + exp ( x [ 2 ] ) ) = 0.7715 + log ( exp ( − 0.7715 ) + exp ( − 0.6205 ) + exp ( − 0.2562 ) = 1.3447266007601868 = 0.7715 + log ( exp ( − 0.7715 ) + exp ( − 0.6205 ) + exp ( − 0.2562 ) = 1.3447266007601868 = 0.7715 + log ( exp ( − 0.7715 ) + exp ( − 0.6205 ) + exp ( − 0.2562 ) = 1.3447 −x[0]+\log(\exp(x[0])+\exp(x[1])+\exp(x[2]))=0.7715+\log(\exp(−0.7715)+\exp(−0.6205)+\exp(−0.2562)\\

=1.3447266007601868=0.7715+\log(\exp(-0.7715)+\exp(-0.6205)+\exp(-0.2562)=1.3447266007601868\\

=0.7715+\log(\exp(−0.7715)+\exp(−0.6205)+\exp(−0.2562)=1.3447 − x [ 0 ] + log ( exp ( x [ 0 ] ) + exp ( x [ 1 ] ) + exp ( x [ 2 ] ) ) = 0 . 7 7 1 5 + log ( exp ( − 0 . 7 7 1 5 ) + exp ( − 0 . 6 2 0 5 ) + exp ( − 0 . 2 5 6 2 ) = 1 . 3 4 4 7 2 6 6 0 0 7 6 0 1 8 6 8 = 0 . 7 7 1 5 + log ( exp ( − 0 . 7 7 1 5 ) + exp ( − 0 . 6 2 0 5 ) + exp ( − 0 . 2 5 6 2 ) = 1 . 3 4 4 7 2 6 6 0 0 7 6 0 1 8 6 8 = 0 . 7 7 1 5 + log ( exp ( − 0 . 7 7 1 5 ) + exp ( − 0 . 6 2 0 5 ) + exp ( − 0 . 2 5 6 2 ) = 1 . 3 4 4 7